過去 1 年間、Google はマップに AI を活用した機能をいくつか追加して、発見を改善し、ユーザーが場所について質問できるようにしてきました。現在、同社はGeminiを使用してアプリをアップグレードし、ユーザーが運転中にAIロボットに質問し、ナビゲーションを改善し、より多くのタスクを実行できるようにしている。

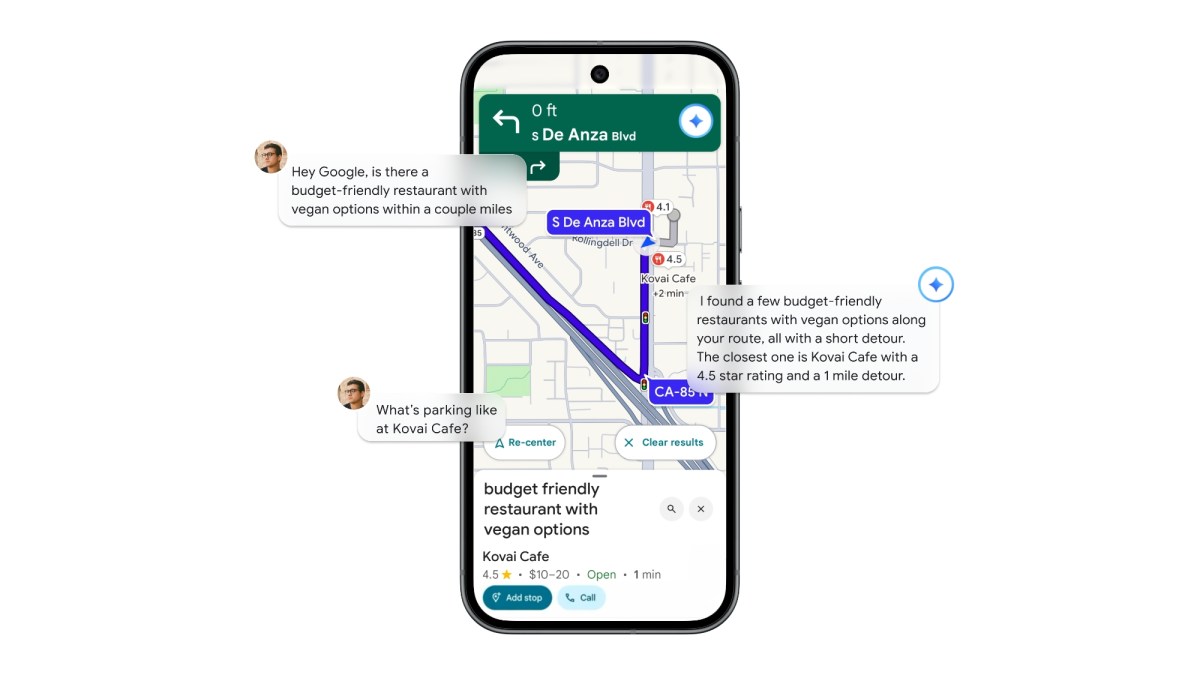

運転中にユーザーは、Gemini にルート上の興味のある場所に関する質問に答えてもらったり、他のトピック (スポーツやニュースなど) に関する結果を返したり、さらにはカレンダーにイベントを追加するなどのタスクを実行したりすることができます。

会話の中で複数の質問をすることもできます。たとえば、「私のルート沿いに、ビーガンのオプションを提供する手頃なレストランはありますか? または数マイル離れたレストランはありますか? … そこの駐車場はどうですか?」

ドライバーは Gemini を使用して交通事故を報告することもでき、マップは前方の道路の混乱をユーザーに積極的に通知します。

Googleはまた、Geminiとストリートビューのデータを組み合わせてナビゲーションの指示を改善する新機能をマップに追加する予定だ。そのため、たとえば 500 フィート進んだところで右折するようユーザーに求める代わりに、マップはガソリン スタンド、レストラン、有名な建物などの近くのランドマークにフラグを立てて、曲がらなければならない前にハイライト表示します。

同社によると、Gemini はストリートビュー画像を使用して 2 億 5,000 万件の場所に関する情報を相互参照し、ナビゲーション用の重要で目に見えるランドマークを特定します。

マップには、Google レンズと連携して、周囲に関する質問に答える機能もあります。そのため、レストランやランドマークなどの興味のある場所にカメラを向けて、「この場所は何ですか、なぜ人気があるのですか?」などの質問をすることができます。

TechCrunchイベント

サンフランシスコ

|

2026 年 10 月 13 ~ 15 日

Googleは、Geminiの新しいナビゲーション機能が今後数週間以内にiOSおよびAndroidデバイスに展開されると述べ、Android Autoのサポートも間もなく開始されると述べた。米国の交通警報は、まず Android ユーザーに展開されます。ランドマーク ナビゲーションは現在、米国の iOS と Android でのみ利用可能です。 Lens with Gemini は今月後半に米国で発売される予定です。